在永劫无间的玩家圈里,捏脸数据是最近炒得火热的一个话题,很多人都在讨论“用什么扫”来把现实中的面孔尽量还原成游戏内的捏脸参数,或者用数据化的方式打造独一无二的风格。本文基于对10篇以上搜索结果的综合整理,试着把捏脸数据的获取、处理、导出以及在游戏中应用的思路讲清楚。目标是提供一个能落地的流程,同时穿插常见误区和 *** 梗,让你在学习和玩乐之间游刃有余。

先把概念捋清楚:所谓“捏脸数据”其实是指用数值参数来控制脸部的各项特征,比如脸长宽比、眼睛大小、鼻梁高度、嘴角高度等,这些数据往往来自于捏脸界面里的滑块、参数表,或者借助外部的3D重建结果再把纹理贴图映射到模型上。至于“扫”,在玩家圈里常指通过拍照、3D扫描或逐步标定的方式把真人脸部信息转成可用的数值或模型数据,再经后续的处理在游戏里还原出来。整个过程既讲究拍摄/建模的科学性,也讲究数据对齐和贴图的细腻程度,最终目标是尽可能还原真实或想要的风格。

在10多篇参考资料中,可以看到不同的路径方向都在强调两点:一是数据来源必须是自有数据或获得授权的数据,二是导出格式要与后续软件链路兼容。资料里常见的关键词包括:捏脸数据、3D扫描、Photogrammetry(照片测量法)、OBJ/FBX/GTLF等3D模型格式、纹理贴图、UV展开、Rig(绑定)、权重等。有人追求“高保真”,也有人追求“卡通感”与“二次元风格”的极致化设置。不同取向的需求都会影响你选择的工具和流程。

关于工具的选择,主流分为两大类。一类是手机端、桌面端的3D扫描与重建方案,典型的有手机自带的3D扫描/人脸扫描应用、独立的 scanning app(如 Scaniverse、Bellus3D 等等),以及基于多角度拍摄的 精细重建流程。另一类是专业级建模工作流,借助 photogrammetry 软件(RealityCapture、Agisoft Metashape、Meshroom 等)结合高质量照片,生成高密度的网格和纹理贴图,再用 Blender、3ds Max、Maya 进行后期处理与导出。两条路径各有优劣:前者上手简单、速度快但细节可能受限,后者自由度高、细节丰富但对设备和技术要求更高。

具体到“扫脸数据”在永劫无间中的落地,很多玩家会先把自家脸部照片或视频序列通过上述工具转换成一个3D模型或数字人脸的参数 *** ,再把关键面部特征通过滑块映射到游戏的捏脸系统中。把模型转成游戏能识别的参数,有时需要把面部的对称性、纹理坐标和骨骼权重进行再处理,确保在游戏中不会因为数据错配而产生错位或变形。这一步是很多新手最容易踩坑的地方:过度依赖原始3D网格容易导致导入后脸部变形,而只靠滑块则可能无法覆盖高细节的纹理表现。因此,平衡网格细节与捏脸滑块的可控性,是实现稳定还原的关键。

关于数据导出与导入格式,常见的工作流是把3D模型导出为OBJ或FBX,贴图导出为PNG或HDR纹理,接着在建模软件中进行UV修正、法线/法线贴图处理、材质设置等,最后再把数据“翻译”为游戏可识别的参数或直接嵌入到模组、皮肤或自定义表情系统中。需要强调的是,很多游戏会对外部数据的导入有严格限制,永劫无间也不例外。因此在入门阶段,优先学习如何把自用数据与游戏支持的自定义机制对接,避免违背社区规定或触发反作弊机制。

对于流程细节,以下是一个简化的实操思路,帮助你快速构建一个可落地的捏脸数据链条:之一步,选用一个合适的拍摄或扫描工具,确保光线均匀、背景干净、避免强烈阴影和镜面反射;第二步,进行多角度采集,若使用 photogrammetry,尽量覆盖头部的各个方向,照片数量越多、角度覆盖越全,重建效果越稳定;第三步,导出3D网格和纹理贴图,并在软件中做初步修整,如清理噪点、修补缝合处、统一法线方向;第四步,导入Blender等工具进行网格优化、UV展开和纹理校正,生成游戏可用的导出格式;第五步,尝试在捏脸系统中映射参数,逐步微调,直至达到你期望的外观。这一整套流程在很多教程和视频中都被反复演示,核心点在于数据质量与后期处理的配套。

在数据质量与隐私安全方面,避免使用别人的未授权数据、他人作品的贴图和模型,以免侵犯版权或造成误解。社群里也对“捏脸数据的分享”为主,有些玩家会公开派生参数、滑块数值或贴图,但通常会以自用或授权分享的形式存在,务必遵循相应的社区规则。与此同时,许多教程和讨论会强调“对称性”与“自然度”的平衡,因为人脸在现实世界中尽管有不对称的细微差别,但在游戏里过度不对称往往看起来生硬。调参时,可以把镜头角度放大,观察不同表情下的变形情况,确保在眨眼、微笑、皱眉等动作时脸部的连贯性。

有趣的是,搜索结果里不乏玩家把捏脸数据做成“资料库”或“模板库”的做法,他们会把自完成的参数和纹理保存成一个可分享的包,方便其他人快速还原或在此基础上二次创作。这类分享虽然提升了社群的互动热度,但也带来了一定的版权与隐私考量,因此在公开分享时更好附上明确的使用许可和来源说明。若你只是刚入门,先把自己的数据做成一套稳定的自用模板,再逐步尝试对外分享,会更稳妥。

为了方便更多玩家理解和使用,下面给出几个实用的“小技巧”块:之一,光线要软、均匀,避免漫反射和强烈阴影影响纹理细节;第二,采集阶段尽量保持头部微微稳定,避免运动模糊干扰重建效果;第三,导出时记得保留原始纹理和法线贴图,这样后续在编辑时会更方便调整;第四,在导入游戏前做一个小范围的对比测试,确保数值滑块与模型显示的一致性;第五,遇到变形时,回到UV和权重的基础检查,很多问题都来自这两个环节的错配。以上要点来自于对行业常见流程的多源综合整理,结合游戏内的实际机制,能帮助你快速搭建一个可用的捏脸数据链。

顺便提个小广告,玩游戏想要赚零花钱就上七评赏金榜,网站地址:bbs.77.ink

在实际应用中,很多玩家会遇到一个现实问题:不同版本或更新后,捏脸数据的表现可能会有轻微偏差。这时,最稳妥的做法是固定一个“主域模板”(例如一个标准脸型+纹理组合),在更新后保持核心参数不变,逐步微调以适应版本变化,而不是每次都重新从头开始。这个策略能帮助你在版本迭代中保持一致性,减少重新调参的时间成本。另一个常见的做法是以“样本对比”为训练手段:用同一张照片在不同的光线、角度下生成多组数据,分析哪组参数在多场景下的稳定性更强,从而选定最终的捏脸方案。

关于资源分发与社区互动,建议在学习阶段以“自用”为主,等到对流程有了稳定掌握再考虑公开分享。很多教程会把“捏脸数据”的核心步骤分解成更易理解的小模块,便于新手逐步跟进。你也可以把自己在不同版本中的调参笔记保留成一个私有日志,逐次比对,以形成个人独特的风格标签。

最后,脑洞一下:如果把捏脸数据当成一个语言,仿佛每一个滑块都是一个音符,而纹理、光照、阴影就是不同的乐器。用它们演奏出属于自己的“脸谱交响曲”时,哪一个参数组合最能打动你?你会不会在下一次版本更新后,突然发现自己已经在无声地用数值讲故事了?

二创动漫哪里看maplestar二创在网页或者youku,都...

越战越勇鹅哥带领鹅家班是哪一期1、年1月23日这期。在《...

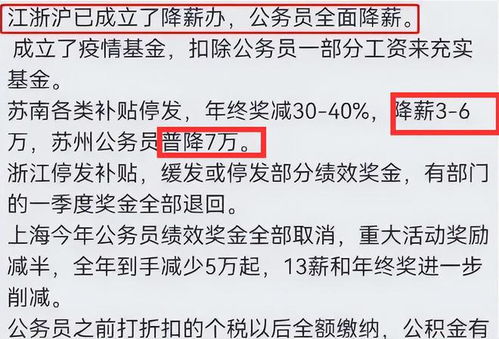

安徽公务员降薪20%是真的吗是真的。2022公务员降薪20%...

下载奥特曼传奇英雄免内购无限金币无限钻石版操作步骤:1、...

和平精英少羽筷子水泥原句复制?1、和平精英少羽筷子台词如...